I robot decideranno per noi? Urge un codice etico

Che cosa facciamo se è un algoritmo a negarci l'accesso all'università o a un mutuo? Che cosa accade se l'opinione pubblica si polarizza in seguito a raccomandazioni automatiche di notizie? E che cosa faremo con i disoccupati il cui lavoro è stato preso da una macchina?

Il prof. Nello Cristianini, docente all'Università di Bristol, in vista dell'imminente Meeting di Rimini, prova a riassumere così le sfide concrete che ci troveremo davanti con lo sviluppo dell'intelligenza artificiale. Posta in questi termini, la questione diventa pressante e diretta, per ciascuno di noi, agganciando alla vita quotidiana una diatriba che altrimenti appare lontana e vaga.

Lo scontro tra apocalittici e tecno-ottimisti sale di tono e indirettamente rivela che la ricerca è ad una svolta strategica. Elon Musk, il padre di Tesla, e Mark Zuckerberg, il patron di Facebook, sono stati i più esposti nello scontro, dandosi a vicenda dell'ignorante e del catastrofista. Ma le schiere delle due fazioni sono assai più folte.

Da una parte sta chi sostiene che il computer non potrà mai battere l'uomo. L'argomentazione più convincente, su questo versante, la porta Federico Faggin, l'inventore dei microchip e del touch screen, che pone la discriminante sulla questione della coscienza. Una macchina - sostiene - non potrà mai avere consapevolezza di se stessa, perché è impossibile "produrre consapevolezza con gli atomi e le molecole della fisica che conosciamo". Se le macchine non hanno consapevolezza, non potranno sfuggire al controllo degli uomini.

Vero, replica il fronte opposto, ma se costruiamo macchine che dialogano tra di loro e che sanno elaborare una marea "disumana" di dati ad una velocità che l'uomo non potrà mai raggiungere, avremo dato vita ad un sistema tecnologico che può sfuggire al nostro controllo. Non avrà consapevolezza, ma potrà avere uguale potenza distruttiva. Non sarà volutamente "cattivo", ma "fuori controllo". Si rischia di meno?

Un segnale preoccupante è arrivato nei giorni scorsi quando in un esperimento di dialogo tra due computer, si è constatato che le macchine se la intendevano benissimo, ma senza che gli analisti riuscissero a comprendere come. È il rischio insito nel "machine learning", il sistema per il quale un computer impara incessantemente dall'esperienza che incontra, dalla infinita gamma di esempi che gli viene fornita, e persino dai propri errori. Con un ulteriore pericolo: che cosa accade se nel sistema - volutamente o involontariamente, in modo dichiarato o subdolo - vengono inseriti modelli distorti? Chi sarà poi in grado di intervenire e correggere? Abbiamo robot che eseguono diagnosi mediche o che stabiliscono polizze assicurative: chi ci dà garanzia sui parametri scelti? Affidiamo scelte che riguardano la vita di persone e comunità al freddo calcolo degli algoritmi. Fede incondizionata nella presunta oggettività della matematica.

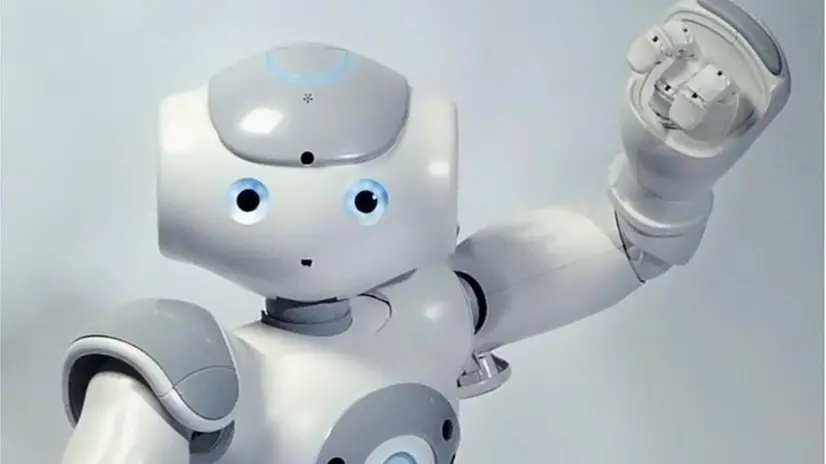

Libera ricerca e libera tecnologia, invoca chi è convinto che una sorta di "mano invisibile" alla fine porterà verso un progresso che ci farà stare tutti meglio. La questione non è diversa da quella che ci pone la ricerca in altri campi. Il robot diventa in questo modo un'estensione biotecnologica. Ed è su questo nodo che varrebbe la pena di porre il punto di incontro tra le ali dialoganti dei due schieramenti.

È indiscutibile che l'intelligenza artificiale ci offre aiuti e risorse preziose, che debba essere sviluppata, ma anche che debba essere posta sotto controllo. Come? Con una sorta di commissione etica, ad esempio, che ponga i confini oltre i quali non sarebbe lecito e saggio andare. E con un processo di condivisione culturale: sapere, comprendere, divulgare e coinvolgere, per non farsi sorprendere.

Di fronte allo sviluppo imprevedibile dell'intelligenza artificiale forse abbiamo bisogno urgente di un codice etico, o almeno di un protocollo d'intesa per convivere con i robot, e non affidare loro le nostre vite a cuor leggero. Ancor di più se, come dice Faggin, non hanno e non potranno avere consapevolezza di loro stessi e quindi delle loro scelte. I computer saranno mostruosamente intelligenti, noi dovremo essere saggi.

Riproduzione riservata © Giornale di Brescia

Iscriviti al canale WhatsApp del GdB e resta aggiornato